대형 모델 번역 인터페이스

대형 모델 일반 인터페이스

여러 대형 모델 인터페이스를 동시에 사용하기?

단순히 여러 개의 다른 키를 번갈아 사용하려면 |로 구분하면 됩니다.

하지만 때로는 여러 개의 다른 API 인터페이스 주소/prompt/model/매개변수 등을 동시에 사용하여 번역 결과를 비교하고 싶을 수 있습니다. 방법은 다음과 같습니다:

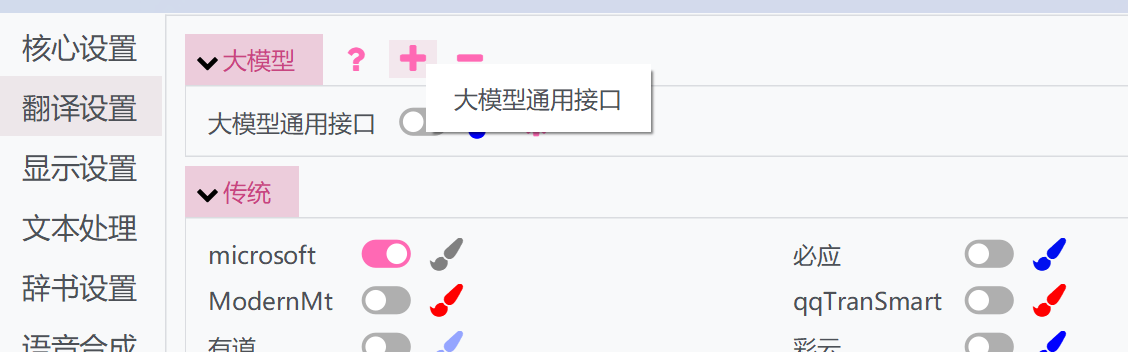

- 상단의 "+" 버튼을 클릭하고 대형 모델 범용 인터페이스를 선택하십시오

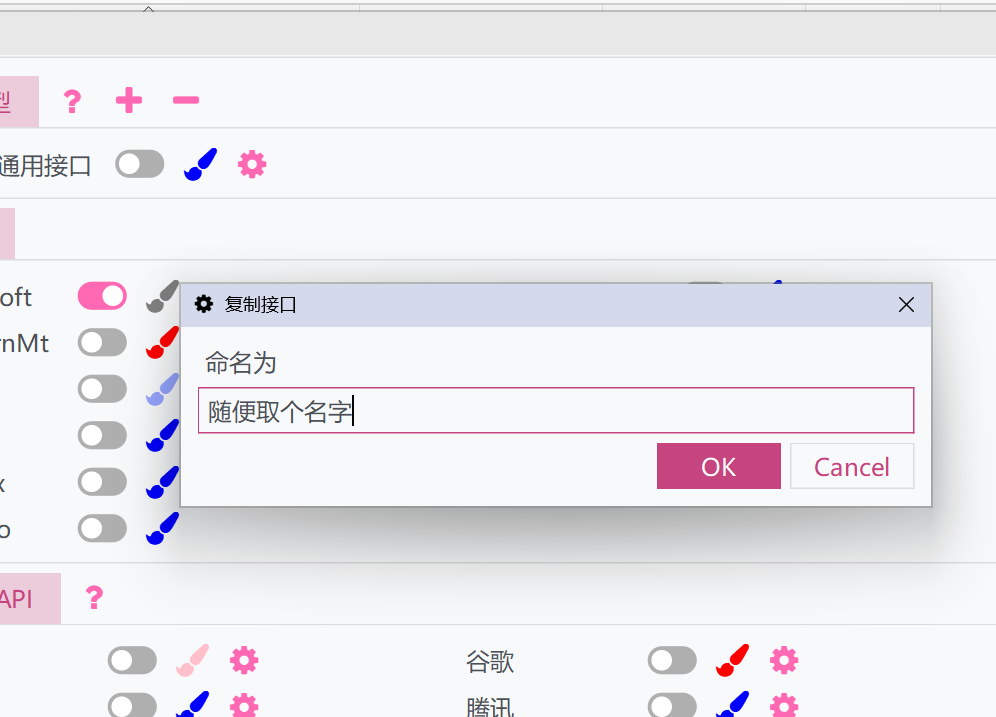

- 창이 팝업됩니다. 이름을 지정하십시오. 이렇게 하면 현재 대형 모델 범용 인터페이스의 설정과 API가 복제됩니다

- 복사된 인터페이스를 활성화하고 개별적으로 설정할 수 있습니다. 복사된 인터페이스는 원본 인터페이스와 함께 실행될 수 있어 서로 다른 여러 설정으로 실행할 수 있습니다.

파라미터 설명

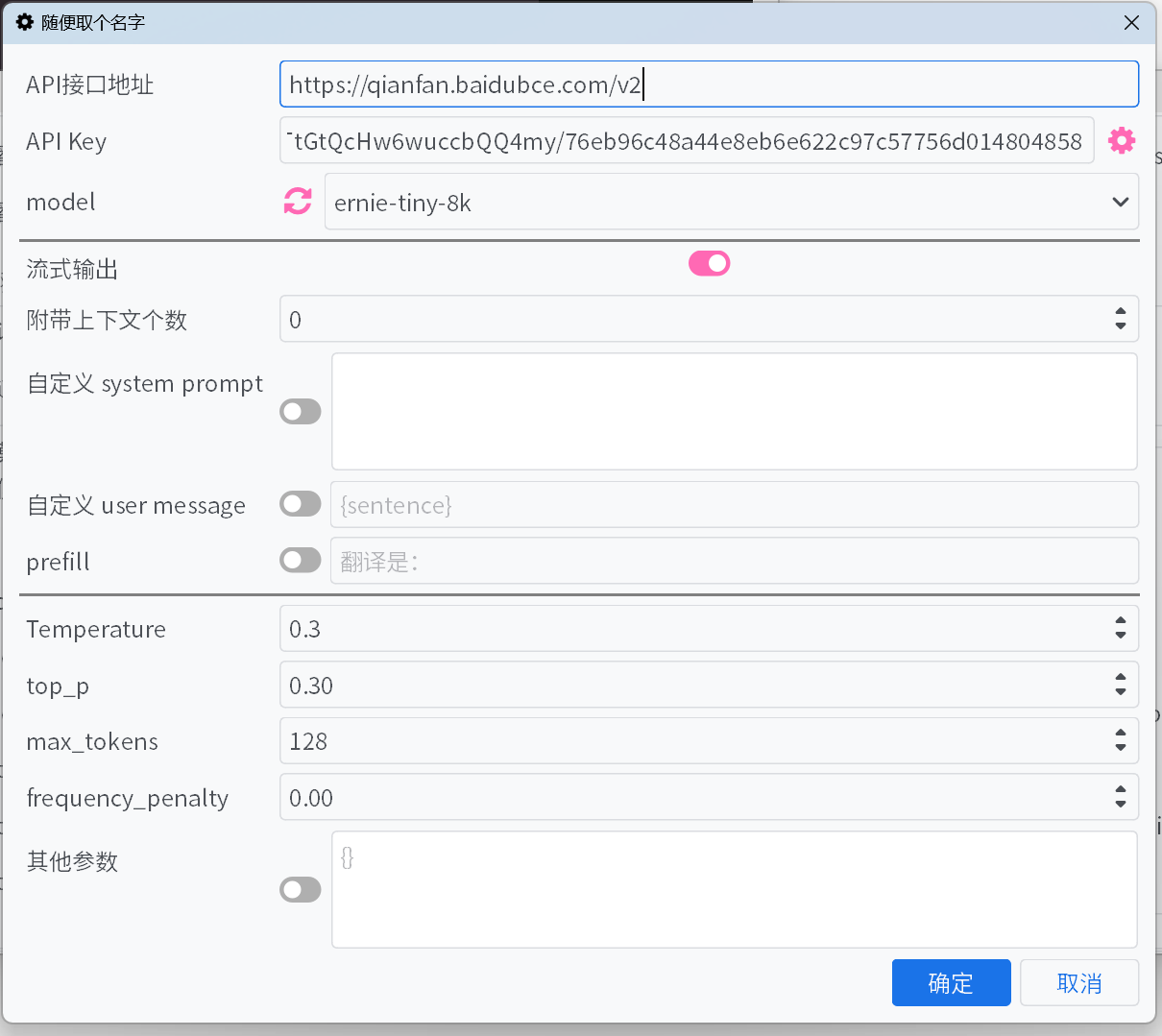

API 인터페이스 주소

대부분의 일반적인 대형 모델 플랫폼의

API 인터페이스 주소는 드롭다운 목록에서 선택할 수 있지만, 누락된 경우가 있을 수 있습니다. 목록에 없는 인터페이스의 경우 플랫폼 문서를 참고하여 직접 입력해 주세요.API Key

API Key는 플랫폼에서 발급받을 수 있습니다. 여러 개의 Key를 추가하면 자동으로 순환하며, 오류 피드백에 따라 Key의 가중치를 조정합니다.model

대부분의 플랫폼에서는

API 인터페이스 주소와API Key를 입력한 후model옆의 새로고침 버튼을 클릭하면 사용 가능한 모델 목록을 가져올 수 있습니다.플랫폼이 모델 목록을 가져오는 인터페이스를 지원하지 않고, 기본 목록에 사용하려는 모델이 없는 경우, 인터페이스 공식 문서를 참고하여 모델을 수동으로 입력해 주세요.

스트리밍 출력

활성화하면 모델의 출력 내용을 증분 방식으로 스트리밍하며, 비활성화 시 모델이 완전히 출력한 후 모든 내용을 한 번에 표시합니다.

사고 과정 숨기기

활성화하면 <think> 태그로 감싼 내용을 표시하지 않습니다. 사고 과정 숨기기가 활성화된 경우 현재 사고 진행 상태를 표시합니다.

첨부할 컨텍스트 개수

이전의 원문과 번역을 몇 개까지 대형 모델에 제공하여 번역을 최적화합니다. 0으로 설정하면 이 최적화 기능이 비활성화됩니다.

- 캐시 적중률 최적화 — DeepSeek 등의 플랫폼에서는 캐시에 적중된 입력에 대해 더 낮은 가격으로 청구됩니다. 활성화하면 컨텍스트 첨부 방식을 최적화하여 캐시 적중률을 높입니다.

사용자 정의 system prompt / 사용자 정의 user message / prefill

출력 내용을 제어하는 여러 가지 방법으로, 선호에 따라 설정하거나 기본값을 사용할 수 있습니다.

사용자 정의 시스템 프롬프트와 사용자 메시지에서 필드를 사용하여 일부 정보를 참조할 수 있습니다:

{sentence}: 현재 번역할 텍스트{srclang}및{tgtlang}: 소스 언어 및 대상 언어. 프롬프트에서 영어만 사용된 경우, 언어 이름의 영어 번역으로 대체됩니다. 그렇지 않은 경우 현재 UI 언어의 언어 이름 번역으로 대체됩니다.{contextOriginal[N]}과{contextTranslation[N]}과{contextTranslation[N]}: N개의 이전 원문, 번역문, 둘 다. N은 "동반 컨텍스트 수"와 관련이 없으며 입력 시 정수로 대체해야 합니다.{DictWithPrompt[XXXXX]}: 이 필드는 "고유 명사 번역" 목록의 항목을 참조할 수 있습니다. 일치하는 항목이 없을 경우, 번역 내용을 손상시키지 않도록 이 필드는 지워집니다. 여기서XXXXX는 LLM이 주어진 항목을 사용하여 번역을 최적화하도록 안내하는 프롬프트로, 사용자 정의할 수 있거나 사용자 지정 메시지를 비활성화하여 기본 프롬프트를 사용할 수 있습니다.

Temperature / max tokens / top p / frequency penalty

일부 플랫폼의 일부 모델에서는

top p및frequency penalty와 같은 매개변수가 인터페이스에서 허용되지 않을 수 있으며, 또는max tokens매개변수가 더 이상 사용되지 않고max completion tokens로 변경되었을 수 있습니다. 이 문제는 스위치를 활성화하거나 비활성화하여 해결할 수 있습니다.reasoning effort

Gemini 플랫폼에서는 이 옵션을 Gemini의

thinkingBudget에 자동으로 매핑합니다. 매핑 규칙은 다음과 같습니다:none/minimal→0(사고 비활성화, 단 Gemini-2.5-Pro 모델에는 적용되지 않음), low→512, medium→-1(동적 사고 활성화), high/xhigh→24576.

기타 파라미터

위에서는 일반적인 파라미터만 제공했습니다. 사용 중인 플랫폼에서 다른 유용한 파라미터를 제공하는 경우 직접 키-값을 추가할 수 있습니다.

일반적인 대형 모델 플랫폼

유럽과 미국의 대규모 모델 플랫폼

중국의 대규모 모델 플랫폼

API 애그리게이션 매니저

new-api와 같은 API 중계 도구를 사용하여 여러 대형 모델 플랫폼 모델과 여러 키를 보다 편리하게 집계 관리할 수도 있습니다.

사용 방법은 이 글을 참조하십시오.